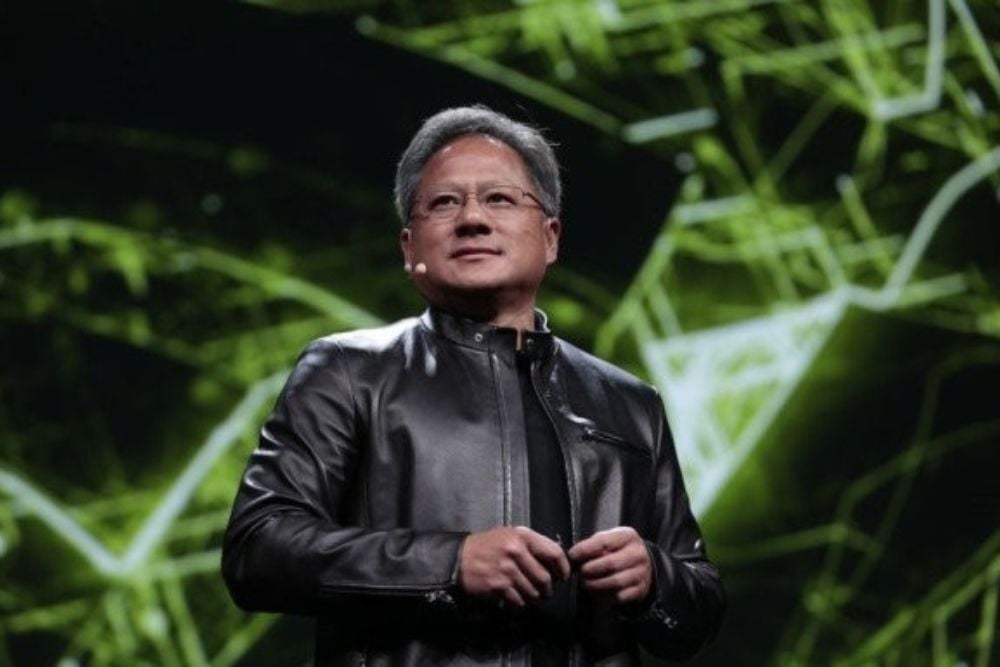

Perkembangan kecerdasan buatan (AI) kini memasuki fase yang lebih menuntut. CEO NVIDIA, Jensen Huang, menyatakan bahwa kecepatan inferensi menjadi kunci dalam menghadirkan pengalaman pengguna yang lebih baik. Inferensi adalah proses di mana model AI membuat prediksi berdasar data baru. Dalam konteks ini, Huang menekankan pentingnya sistem komputasi awan yang lebih robust.

Dalam penjelasannya, Huang menjelaskan bahwa inferensi saat ini menjadi fase yang paling intensif dalam komputasi AI. “Inferensi telah menjadi fase AI yang membutuhkan komputasi paling intensif,” katanya. Proses ini memerlukan penalaran secara real-time di skala global, sehingga memerlukan dukungan infrastruktur yang mumpuni.

NVIDIA bersama Akamai telah memperkenalkan sistem komputasi yang memindahkan inferensi lebih dekat ke pengguna. Langkah ini diharapkan dapat menghadirkan generative AI dengan kecepatan dan skalabilitas yang lebih baik. “Fase baru ini segera hadir,” imbuh Huang, menunjukkan optimisme terhadap kolaborasi kedua perusahaan.

Infrastruktur Komputasi Awal yang Kuat

Kerja sama ini melahirkan platform baru bernama Akamai Cloud Inference. Platform ini dilengkapi dengan komponen canggih seperti Server NVIDIA RTX PRO dan DPU NVIDIA BlueField-3. Selain itu, perangkat lunak NVIDIA AI Enterprise juga menjadi bagian dari sistem. Kombinasi ini menawarkan pemrosesan edge AI berlatensi rendah. Hal ini bertujuan untuk menciptakan pengalaman digital yang lebih responsif.

Akamai Cloud Inference memanfaatkan lebih dari 4.200 lokasi jaringan edge global miliknya. Dengan arsitektur terdistribusi ini, inferensi dapat dilakukan lebih dekat dengan pengguna. Keunggulan utama dari sistem ini ialah kemampuannya untuk menyediakan pemrosesan yang cepat dan efisien.

Transformasi Melalui Teknologi Terdistribusi

Huang menjelaskan bahwa beban kerja berbasis agen kini semakin meningkat. Permintaan akan inferensi berlatensi rendah menjadi krusial. Oleh karena itu, Akamai mengembangkan platform edge generatif untuk menjawab tantangan ini. “Dengan dukungan infrastruktur AI NVIDIA, Akamai Inference Cloud akan memperluas inferensi AI ke ribuan lokasi di seluruh dunia,” tutupnya.

Aplikasi terbaru dalam AI mencakup berbagai aspek, mulai dari pengalaman pengguna yang dipersonalisasi hingga sistem pengambilan keputusan secara real-time. Hal ini menuntut inferensi untuk dilaksanakan dekat dengan lokasi di mana data dihasilkan. Seiring dengan ini, rute permintaan dapat ditentukan secara cerdas untuk memberikan respons yang lebih cepat.

Peran Orkestrasi Cerdas dalam Cloud Inference

Sistem Akamai Cloud Inference diatur untuk menangani beban kerja AI yang kompleks. Orkestrasi cerdas di dalam platform ini secara otomatis merutekan tugas ke lokasi yang paling optimal. Ini memastikan bahwa inferensi rutin dapat dijalankan dengan efisien melalui layanan mikro NVIDIA NIM. Penalaran yang lebih rumit akan diproses di AI Factories yang terpusat.

Menurut Tom Leighton, CEO Akamai, kemampuan ini menjadi penting mengingat pertumbuhan permintaan. Platform ini dirancang untuk menyederhanakan kompleksitas infrastruktur AI. Dengan demikian, dedikasi akan keahlian terintegrasi menjadi sumber daya yang sangat dibutuhkan untuk mendukung pengembangan AI lebih lanjut.

Inovasi dalam teknologi pemrosesan AI ini meletakkan dasar bagi masa depan yang lebih cerdas dan responsif. Dengan kolaborasi antara NVIDIA dan Akamai, dipastikan bahwa AI akan terus beradaptasi untuk memenuhi kebutuhan yang semakin meningkat.

Baca selengkapnya di: teknologi.bisnis.com